فهرست موضوعات در این آموزش

همه چیز درباره فایل robots.txt

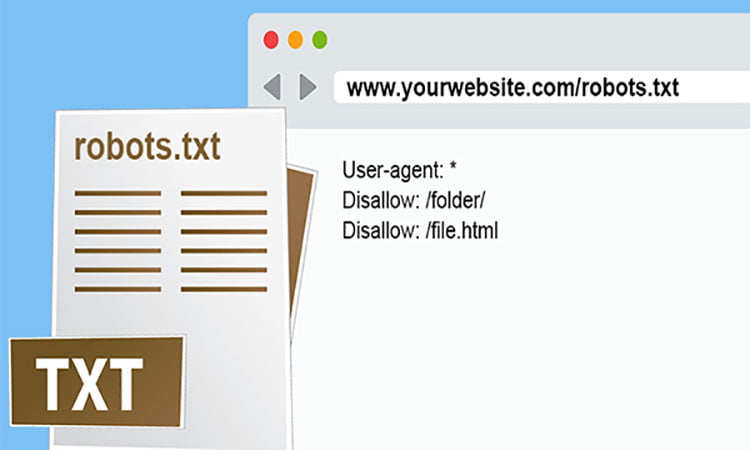

Robots.txtشاید برای شما این سوال به وجود بیاید که فایل robots.txt چیست؟ و یا نحوه ساخت آن چگونه میباشد؟ نقشه سایت یک فایل متنی است که مدیران وب آن را برای موتورهای جستجو ایجاد میکنند که چگونگی کرال کردن صفحات در وبسایتشان مشخص شود. بهتر است بدانید که این فایل شامل دستورالعملهایی مانند رباتهای متا، دستورالعملهای صفحه، زیردایرکتوری یا سراسر سایت برای نحوه برخورد موتورهای جستجو با لینکها مانند follow یا nofollow است.

به طور کلی فایل robots.txt مجموعه ای از دستورالعمل هایی برای ربات های گوگل است، این فایل مانند هر فایل دیگری در وب سایت بر روی وب سرور میزبانی می شود و برای مشاهده کردن آن در هر سایتی تنها کافی است تا رو به روی URL اصلی سایت خود فایل زیر را اضافه کنید.

کاربرد فایل TXT

امروزه یکی از کاربردی ترین فرمت ها در سئو سایت، فایل TXT می باشد. درون این فایل ها در حقیقت نوعی متن استاندارد وجود دارد که با استفاده از NOTE PAD و یا TEXT EDIT به ترتیب در سیستم عامل های ویندوز و مک نوشته می شوند. قالب فایل TXT بسیار ساده است و از هیچ قالب بندی ای پیروی نمی کند. شما می توانید با استفاده از هر اپلیکیشن ویرایش متنی، آنها را تغییر دهید. از مهم ترین کاربر این فرمت ها می توان به فایل ROBOTS در سئو سایت اشاره کرد. در ادامه می پردازیم به بررسی این نوع از فایل ها، کاربردشان، نحوه استفاده و ساخت آنها، پس با ما باشید.

فایل ROBOTS.TXT چیست؟

یکی از مهم ترین تکنیک های سئو تکنیکال استفاده از فایل ROBOTS.TXT می باشد. شما با استفاده از این فایل ها می توانید صفحات سایت خود را در جهت ایندکس شدن و یا مشاهده ی آنها توسط ربات های گوگل، بهینه سازی کنید. در حقیقت این فایل ها ربات های جستجوگر گوگل را برای خزیدن بین صفحات سایت شما هدایت می کند. اما باید توجه داشته باشید که نحوه استفاده و همچنین ساختن آنها به دانش خاص خود نیاز داشته که ما در این مقاله به آنها می پردازیم.

به نوعی شما با استفاده از فایل های ROBOTS.TXT می توانید دسته ای از صفحات را به صورت کلی برای ربات های گوگل غیر قابل بازدید کنید. عملکرد این فایل ها شباهت بسیار زیادی به تگ NOINDEX داشته، اما با آن متفاوت است. اگر در بخش هد هر صفحه تگ نوایندکس اضافه کنید آن صفحه دیگر ایندکس نخواهد شد. (گاها این استثنا وجود دارد که صفحه ما با وجود تگ نوایندکس همچنان توسط کراولر ها خزیده می شوند.)

دلایل بهره مندی از ROBOTS.TXT

مزایای بهره مندی از ROBOTS.TXT

مدیریت ربات های گوگل برای دسترسی به صفحات سایت

امروزه یکی از مهم ترین کاربرد های استفاده از فایل ROBOTS، مدیریت ربات های گوگل در جهت دسترسی آنها به صفحات، محتواها و فایل های موجود در سایت می باشد. چراکه اگر برخی از فایل ها و یا صفحات توسط ربات های گوگل بررسی شوند، تاثیر بسیار بدی به روی سئو سایت می گذارد. ممکن است برخی از سایت ها مجبور باشند تا از محتوا و یا فایل هایی استفاده کنند که قوانین گوگل را نقض کند، اما برای برخی از کاربران ضروری است.

افزایش سرعت بازدید ربات های گوگل از سایت شما

یکی دیگر از مهم ترین دلایل استفاده از فایل ROBOTS افزایش سرعت بازدید ربات های گوگل از صفحات سایت شما می باشد. چراکه هر چه اطلاعات و یا صفحات کمتری در سایت شما موجود باشد، ربات ها و یا کراول های گوگل با سرعت بیشتری صفحات سایت شما را بررسی می نمایند. در نتیجه صفحات سایت سریعتر ایندکس می شوند.

مدیریت لینک ها با ROBOTS.TXT

دیگر مزایای استفاده از فایل ROBOTS بهره مندی از URL CLOACKING و یا پنهان کردن آدرس صفحات سایت می باشد. شما با استفاده از این تکنیک سئو سایت می توانید مطالب متفاوتی را به کاربران و همچنین موتورهای جستجوگر گوگل نشان دهید. اما در استفاده از آن باید بسیار محتاط باشید، چرا که URL CLOACKING یک سئو کلاه سیاه بوده و حتما باید توسط افراد متخصص در سئو انجام شود.

بررسی کاربرد دستورات فایل ROBOTS

با استفاده از یک سری دستورات در فایل های روبوتس می توانید میزان دسترسی کاربران و همچنین ربات های گوگل را مشخص نمایید. در ادامه می پردازیم به این دستورات:

درباره کاربرد دستورات فایل ROBOTS

دستور USER-AGENT

شما می توانید از دستور USER-AGENT در دو حالت به ربات های گوگل دستور دهید. در حال اول شما می توانید با استفاده از ستاره و یا * به تمام ربات های گوگل دستور دهید. و در حالت دیگر اگر قصد دارید تا تنها یک ربات خاص از دستور شما پیروی کند، باید نام ربات را در مقابل تگ USER-AGENT قرار دهید.

دستور DISALLOW

شما با استفاده از این دستور می توانید به ربات های گوگل دستور دهید تا از چه مطالب و یا صفحاتی از سایت شما بازدید نکنند. به طور مثال اگر می خواهید تا از ایندکس شدن عکس های سایت خود امتناع کنید، در ابتدا باید تمامی عکس های خود را درون یک پوشه در هاست خود ریخته و سپس آدرس آن را در فایل ROBOTS وارد کنید. برای انجام این کار می توانید به صورت زیر بنویسید:

USER-AGENT: *

DISALLOW: /PHOTOS

دستور ALLOW

شما با استفاده از این دستور در فایل ROBOTS می توانید مشخص کنید تا کدام فایل در یک فایلی که DISALLOW می باشد، مجاز به دیده شدن توسط ربات های گوگل می باشد.

نحوه ساخت و استفاده از فایل ROBOTS

یکی از مهم ترین نکاتی که قبل از ساخت این فایل ها باید به آن توجه داشته باشید این است که در ابتدا بررسی کنید که آیا سایت شما در گذشته این فایل برای آن تولید شده است یا خیر. که برای فهمیدن آن می توانید وب سایت خود را همانند زیر در گوگل وارد نموده و سپس دکمه اینتر را فشار دهید.

www.seoiran.com/robots.txt

آموزش ساخت و استفاده از فایل ROBOTS

در صورتی که با صفحه ERROR 404 رو به رو شدید، یعنی برای سایت شما هیچ گونه فایل ROBOTS تولید نشده است. اما در صورتی مشاهده دستورات ROBOTS.TXT باید با استفاده از هاست خود آن را تغییر دهید. در غیر اینصورت می توانید با ساخت یک فایل TXT با استفاده از ابزار های مربوطه همچون نوت پد اقدام به ایجاد یک فایل ROBOTS برای سایت خود کنید. و در نهایت آن را در کنترل پنل هاست و یا از طریق FTP در روت سایت ذخیره کنید.

باید توجه داشته باشید که ایجاد فایل robots.txt برای هر سایتی الزامی نمیباشد زیرا گوگل میتواند تمام صفحات شما را پیدا کرده و آنها را فهرست بندی کند و صفحاتی را که در سایت شما مهم نیستند و یا تکراری هستند را از لیست خود حذف کنند. به طور کلی 3 دلیل اصلی برای ایجاد فایل robots.txt وجود دارد که در ادامه مطلب این 3 دلیل را به طور کامل برای شما شرح داده شده است.

نمونه ای از فایل robots.txt

در ادامه میتواند دو نمونه از فایلهای robots.txt را مشاهده نمایید:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

——————

* :User-agent

Disallow: wp-admin

Sitemap: https://www.seoiran.com.com

مسدود کردن صفحات غیر عمومی

گاهی اوقات ممکن است صفحاتی در سایت خود داشته باشید که نمی خواهید ایندکس شوند. به عنوان مثال، ممکن است یک نسخه مرحلهبندی از یک صفحه داشته باشید اما شما نمی خواهید افراد تصادفی روی آنها فرود بیایند، معمولا صفحات ورود به سایت نیز در فایل های robots.txt وجود دارند زیرا با قرار دادن این صفحات در فایل خود میتوانید به مسدود کردن صفحات و جلوگیری از کرال شدن آنها توسط گوگل استفاده کنید.

کاهش کرال کردن سایت توسط خزنده های گوگل

اگر برای ایندکس شدن همه صفحات خود با مشکل مواجه هستید، ممکن است مشکل بودجه خزیدن داشته باشید، با مسدود کردن صفحات بیاهمیت با robots.txt، Googlebot میتواند بیشتر از بودجه خزیدن شما را صرف صفحاتی کند که واقعاً مهم هستند.

مخفی کردن کل وبسایت از گوگل

یکی دیگر از کاربرهای استفاده از فایل robots.txt مخفی کردن کل سایت از گوگل است، توجه داشته باشید که مخفی کردن کل سایت از گوگل به هیچ عنوان توصیه نمیشود، برای انجام این کار تنها کافی است “Disallow: /” بعد از URL سایت خود قرار دهید.

robots.txt چگونه کار می کند؟

موتورهای جستجو دو کار اصلی دارند که شامل خزیدن در وب برای کشف محتوا و ایندکس کردن آن محتوا به طوری که بتوان آن را برای جستجوگرانی که به دنبال اطلاعات هستند ارائه کرد؛ برای خزیدن کرالرهای گوگل در سایتها، موتورهای جستجو پیوندها را دنبال میکنند تا از یک سایت به سایت دیگر برسند و در نهایت در میان میلیاردها لینک و وبسایت خزیده میشوند.

خزنده جستجو پس از رسیدن به یک وب سایت اما قبل از spider کردن آن، به دنبال فایل robots.txt یا نقشه سایت می گردد. اگر یکی را پیدا کرد، خزنده ابتدا آن فایل را قبل از ادامه صفحه می خواند، از آنجایی که فایل robots.txt حاوی اطلاعاتی در مورد نحوه خزیدن موتور جستجو است؛ اطلاعاتی که در آنجا یافت میشود اقدامات بیشتر خزنده را در این سایت خاص راهنمایی میکند. اگر فایل robots.txt حاوی هیچ دستورالعملی نباشد که فعالیت یک کاربر عامل را ممنوع کند (یا اگر سایت فایل robots.txt نداشته باشد)، به خزیدن اطلاعات دیگر در سایت ادامه خواهد داد.

رابطه فایل ROBOTS با سئو سایت

یکی از مهم ترین نکاتی که باید حتما به آن بپردازید، بررسی فایل ROBOTS سایت خود در جهت جلوگیری از مسدود نبودن بخش های مهم سایت. برای انجام این آزمایش می توانید از سرچ کنسول سایت خود استفاده کنید.

ارتباط فایل ROBOTS با سئو سایت

- در مسدود کردن فایل های سایت خود بسیار دقت کنید تا فایل هایی همچون CSS و یا فایل های JS سایت شما مسدود نباشد. چراکه در صورت مسدود بودن عواقب بسیار بدی در انتظار سایت شما خواهد بود.

- باید توجه داشته باشید که در صورتی که از پنل وردپرس برای سایت خود استفاده می کنید احتیاجی به مسدود کردن فایل های WP-ADMIN و… سایت خود را ندارید، چرا که این عمل توسط تگ های متای موجود در این پنل انجام می شود.

- ترجیحا سعی کنید از دستورات زیادی استفاده نکنید تا دچار سئو کلاه سیاه نشوید.

بیشتر بدانید: چه مواردی به سئو سایت آسیب می رسانند؟

چرا به robots.txt نیاز دارید؟

فایل های Robots.txt دسترسی خزنده به مناطق خاصی از سایت شما را کنترل می کنند. در حالی که اگر شما به طور تصادفی Googlebot را از خزیدن در کل سایت خود منع کنید، می تواند بسیار خطرناک باشد؛ در مواردی وجود دارد که فایل robots.txt می تواند بسیار مفید باشد. در ادامه برخی از موارد استفاده رایج از فایل Robots.txtشرح داده شده است:

-

- جلوگیری از نمایش محتوای تکراری در SERP توجه داشته باشید که متا روبات ها اغلب انتخاب بهتری برای این کار هستند.

- تعیین مکان نقشه سایت جلوگیری از ایندکس کردن فایل های خاص در وب سایت شما(تصاویر، PDF و غیره توسط موتورهای جستجو

- تعیین تأخیر خزیدن به منظور جلوگیری از بارگیری بیش از حد سرورهای شما هنگام بارگیری همزمان چند قطعه محتوا توسط خزنده ها

- اگر هیچ ناحیه ای در سایت شما وجود ندارد که بخواهید دسترسی عامل کاربر به آن را کنترل کنید، ممکن است اصلاً به فایل txt نیاز نداشته باشید.

جمع بندی درباره فایل های تکست ROBOTS

امروزه یکی از مهم ترین کاربرد ها و یا استفاده هایی که از فایل TXT می شود در سئو سایت است. چرا که شما با استفاده از این فرمت می توانید فایل ROBOTS را که یک تکنیک سئو می باشد، برای سایت خود ایجاد کنید. اما باید دقت داشته باشید که این تکنیک بسیار حساس بوده و حتما باید توسط یک متخصص سئو انجام شود.

چرا که ممکن است شما با استفاده از این تکنیک مرتکب سئو کلاه سیاه برای سایت خود شوید. همچنین با خواندن این مقاله آموختید که ساخت این فایل ها بسیار آسان بوده و با استفاده از یک سری دستورات مخصوص انجام می شود. همچنین اگر قصد دریافت خدمات سئو از یک شرکت سئو را دارید، سئو ایران می توانید به خوبی نیاز شما را برطرف نماید.

2 Comments

اگر یک سایت فایل ربات تی اکس تی نداشته باشه چی میشه؟

اتفاقی که می افتد این است که صفحاتی مانند لاگین ادمین سایت نیز ممکن است توسط خزنده ها، کراول شود.